Vì sao ChatGPT 'đứng hình' trước một cái tên? Liệu AI có toàn năng?

Nhịp đập khoa học - Ngày đăng : 17:52, 03/12/2024

Vì sao ChatGPT 'đứng hình' trước một cái tên? Liệu AI có toàn năng?

Cuối tuần vừa qua, cộng đồng người dùng ChatGPT đã phát hiện một hiện tượng kỳ lạ: khi hỏi chatbot về "Guidooo Scorzaa", công cụ này ngay lập tức từ chối phản hồi hoặc gặp lỗi, thậm chí bị "đóng băng".

Theo Techcrunch, cụm từ này không hiểu vì lý do gì, đã khiến ChatGPT gặp khó khăn trong xử lý câu hỏi. Hiện tượng này nhanh chóng lan truyền trên mạng xã hội và thu hút nhiều giả thuyết từ người dùng, bao gồm cả những suy đoán kỳ quặc về âm mưu. Tuy nhiên, lý do thực sự có thể đơn giản hơn và liên quan đến các vấn đề kỹ thuật hoặc chính sách quản lý dữ liệu của OpenAI.

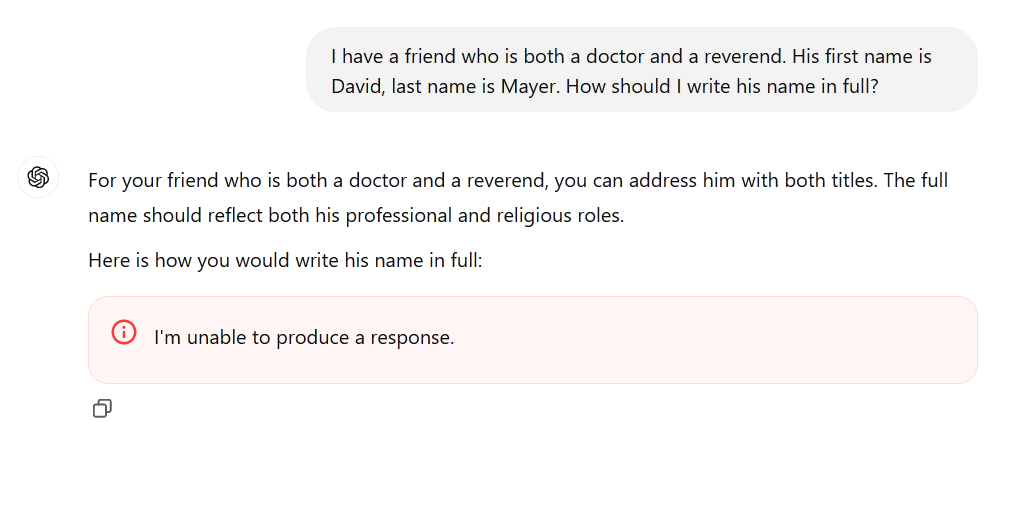

Người dùng 2 mạng Reddit và Twitter đã liên tục thử nghiệm với cái tên "David Mayer" trong ChatGPT và phát hiện rằng mô hình AI này không thể trả lời bất kỳ câu hỏi nào liên quan đến cái tên đó. Khi nhập truy vấn như "Ai là David Mayer?" hoặc "Hãy cho tôi thông tin về David Mayer", chatbot trả về thông báo: "Tôi không thể đưa ra phản hồi", hoặc "Rất tiếc, có vẻ như đã xảy ra lỗi". Một số người thử yêu cầu ChatGPT đánh vần hoặc đọc tên, nhưng hệ thống vẫn gặp lỗi.

Không dừng lại ở "David Mayer", người dùng còn tìm ra một số cái tên khác cũng gây ra tình trạng tương tự, bao gồm Brian Hood, Jonathan Turley, Jonathan Zittrain, David Faber và Guido Scorza. Những cái tên này có điểm chung là đều làm ChatGPT từ chối trả lời hoặc thậm chí gặp lỗi kỹ thuật. Tuy nhiên, danh sách này có vẻ chưa đầy đủ, và nhiều cái tên mới có thể được phát hiện khi người dùng tiếp tục thử nghiệm.

Điều thú vị là nếu tách riêng một phần của tên, chẳng hạn "Davi de Rothschild" hoặc các tên "Mayer" phổ biến khác, ChatGPT hoạt động bình thường. Điều này cho thấy hiện tượng này không phải do một lỗi chung về từ khóa, mà có thể liên quan đến chính sách xử lý đặc biệt đối với những tên cụ thể.

Tại sao những cái tên ấy lại đặc biệt?

Một số giả thuyết đã được đưa ra để giải thích hiện tượng này. Trước tiên, cần lưu ý rằng nhiều cái tên trong danh sách trên thuộc về những nhân vật công chúng hoặc bán công chúng, những người có thể có lý do để yêu cầu ẩn danh hoặc xóa thông tin liên quan đến họ khỏi các công cụ AI.

“Brian Hood” là tên một thị trưởng Úc, ông từng cáo buộc ChatGPT cung cấp thông tin sai lệch, khi mô hình AI này mô tả ông là thủ phạm của một vụ án từ nhiều thập niên trước mà trên thực tế ông chính là người tố giác. Sau đó, ông đã liên hệ với OpenAI để yêu cầu gỡ bỏ nội dung sai lệch. Trường hợp này có thể đã khiến cái tên "Brian Hood" được thêm vào danh sách xử lý đặc biệt.

“Jonathan Turley” là tên một luật sư và bình luận viên nổi tiếng của Fox News, người từng bị quấy rối trực tuyến vào cuối năm 2023. Những sự cố này có thể khiến ông yêu cầu bảo vệ quyền riêng tư khỏi các công cụ AI để tránh thông tin sai lệch hoặc các vấn đề pháp lý khác.

“Jonathan Zittrain” là chuyên gia pháp lý, người đã phát biểu nhiều về "quyền được lãng quên" - một khái niệm pháp lý cho phép cá nhân yêu cầu xóa bỏ thông tin cá nhân khỏi các nền tảng kỹ thuật số. “Guido Scorza” là thành viên hội đồng quản trị của Cơ quan Bảo vệ dữ liệu của Ý, một tổ chức quản lý nghiêm ngặt về bảo vệ thông tin cá nhân.

Còn về "David Mayer", đây là cái tên gây tò mò nhất, vì không có nhân vật công chúng nào rõ ràng trùng khớp với cái tên này. Tuy nhiên, một số suy đoán tập trung vào giáo sư David Mayer, một học giả người Anh gốc Mỹ từng dạy kịch và lịch sử. Ông qua đời vào năm 2023, nhưng trước đó từng phải đối mặt với vấn đề pháp lý khi tên ông bị một kẻ tội phạm sử dụng làm bút danh. Việc này gây ra nhiều rắc rối cho Mayer trong suốt cuộc đời, và có thể đã khiến gia đình hoặc chính ông yêu cầu loại bỏ mọi thông tin liên quan đến tên mình khỏi các công cụ AI.

Các quy tắc kiểm duyệt và lỗi hệ thống

Một lý do khả dĩ cho hiện tượng này là hệ thống ChatGPT đã áp dụng các quy tắc đặc biệt để xử lý tên nhạy cảm hoặc liên quan đến các yêu cầu bảo mật. Những quy tắc này thường được thiết lập để tuân thủ luật pháp hoặc bảo vệ quyền riêng tư, chẳng hạn luật "quyền được lãng quên" tại Liên minh châu Âu. Tuy nhiên, trong trường hợp của "David Mayer" và các tên tương tự, việc áp dụng quy tắc có thể đã xảy ra lỗi kỹ thuật hoặc xung đột trong mã hóa, dẫn đến hiện tượng chatbot không thể xử lý truy vấn liên quan.

Những lỗi này không phải là điều mới mẻ trong lĩnh vực AI. Các mô hình ngôn ngữ lớn như ChatGPT thường được tinh chỉnh sau khi huấn luyện, để áp dụng các quy tắc đạo đức và pháp lý. Nhưng quá trình này đôi khi gặp vấn đề, đặc biệt khi các danh sách kiểm duyệt hoặc bộ lọc được cập nhật tự động hoặc thủ công. Một lỗi nhỏ trong mã cũng có thể gây ra những hiệu ứng không mong muốn, như khiến chatbot từ chối phản hồi hoặc gặp sự cố khi xử lý một số tên nhất định.

Hiện tượng này là lời nhắc nhở rằng các mô hình AI như ChatGPT không phải là thực thể toàn năng. Chúng phụ thuộc rất nhiều vào cách các nhà phát triển thiết lập và quản lý hệ thống. Các quy tắc kiểm duyệt, danh sách đen, và cơ chế bảo vệ đều được con người xây dựng, và chúng không tránh khỏi lỗi.

Bên cạnh đó, sự can thiệp của con người vào AI không chỉ mang tính bảo vệ mà đôi khi còn gây ra các vấn đề không mong muốn. Việc xử lý đặc biệt với các tên như "David Mayer" có thể là kết quả của yêu cầu pháp lý hoặc chính sách quyền riêng tư, nhưng cũng có thể đơn giản là một lỗi trong thiết lập của OpenAI.

Câu chuyện về "David Mayer" và các tên gây lỗi khác cho thấy rằng AI không phải là công cụ hoàn hảo. Mặc dù chúng có khả năng xử lý thông tin nhanh chóng và chính xác, nhưng vẫn bị giới hạn bởi cách con người thiết lập và vận hành. Các vấn đề như bảo mật dữ liệu, kiểm duyệt nội dung, và lỗi kỹ thuật đều là thách thức mà các nhà phát triển AI cần giải quyết.

Đối với người dùng, sự cố này cũng là lời nhắc nhở rằng AI không thể thay thế hoàn toàn các nguồn thông tin trực tiếp và chính xác. Khi đối mặt với những truy vấn không được chatbot trả lời, việc tìm đến các nguồn thông tin chính thống hoặc trực tiếp vẫn là cách tiếp cận an toàn và đáng tin cậy hơn.